前记 Asyncio在经过一段时间的发展以及获取Curio等第三方库的经验来提供更多的功能,目前高级功能也基本完善,但是相对于其他语言,Python的Asyncio高级功能还是不够的,但好在Asyncio的低级API也比较完善,开发者可以通过参考Asyncio高级API的例子来自己实现一些功能,同时也可以通过这些功能更加了解Asyncio的原理和避免踩到高级API的坑。

0.基础 在《Python Asyncio调度原理》 中介绍了Asyncio的两种调度基本单位,Handler和TimeHandler,他们只能被loop.call_xx函数调用,开发者从表面上不知道他们的存在,他们和loop.call_xx属于事件循环的基础功能,但是这些操作都属于单一操作,需要开发者自己编写代码把他们的操作给串联起来。《Python的可等待对象在Asyncio的作用》 中介绍了协程链的发起者asyncio.Task能通过loop.call_soon跟事件循环进行交互,并串联整个协程链中可等待对象以及安排可等待对象的运行。loop.call_at和loop.call_later仍需要开发者通过asyncio.Future来把Timehandler的执行结果与asyncio.Task给串联起来,比如休眠一秒的代码实现:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 import asyncioasync def main ():def _on_complete ():True )1 , _on_complete)return await fif __name__ == "__main__" :import time

这段代码中asyncio.Future执行的是类似容器的功能,自己本身会接受各种状态,并把自己的状态同步给管理当前协程链的asyncio.Task,使asyncio.Task能管理其他类型的操作。

在asyncio.tasks模块中的所有功能函数的原理也差不多,他们接受的参数基本是都是可等待对象,然后通过asyncio.Futurte作为容器来同步调用端和可等待对象间的状态,也可以通过其他的一些方法把asyncio.Task的状态同步给可等待对象。

1.休眠–asyncio.sleep asyncio.sleep是一个常用的方法,开发者通过它可以很方便的让协程休眠设定的时间,它本身也非常简单,它的源码如下:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 @types.coroutine def __sleep0 ():yield async def sleep (delay, result=None ):"""Coroutine that completes after a given time (in seconds).""" if delay <= 0 :await __sleep0()return resulttry :return await futurefinally :

通过源码可以发现当设置的休眠时间等于小于0的时候,sleep只执行了yield,并不会执行其他逻辑,而在值大于0时会创建一个Future对象,接着就一直等待,直到Future对象被loop.call_later控制结束时才返回结果值。

需要注意的是,当asyncio.sleep在值为0时,sleep执行yield可以让Task.__step感知而让出控制权,这是最小的让出当前协程控制权的方法,所以我们在编写涉及到CPU比较多的时候或者消耗时间较长的函数时可以通过asyncio.sleep(0)来主动让出控制权,如下:

1 2 3 4 5 6 7 import asyncioasync def demo () -> None :for index, i in enumerate (range (10000 )):if index % 100 == 0 :await asyncio.sleep(0 )

在这个例子中每循环100次就让出控制权,以减少对其他协程的影响。

2.屏蔽取消–asyncio.shield asyncio.shield可以保护一个可等待对象被取消,或者说是防止协程链上的取消传播到被asyncio.shield托管的可等待对象,但是调用可等待对象的cancel方法仍然可以取消可等待对象的运行,如下例子:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 import asyncioasync def sub (f ):await asyncio.shield(f)async def main ():await asyncio.sleep(0 ) "f1 future run success:" , f1.done())"f2 future run success:" , f2.done())"sub1 future run result:" , sub1.done())"sub2 future run result:" , sub2.done())

其中f1, f2都在main函数中创建, 然后同时被sub函数包裹,并通过asyncio.create_task在后台异步运行并分别返回sub1和sub2两个Future对应着sub函数的执行情况。f1和sub2的执行,并把f1,f2,sub1,sub2是否为done打印出来,可以发现f1,sub1,sub2的状态都为done(被取消也认为是done),而f2则还在运行中。

在文章《Python的可等待对象在Asyncio的作用》 中说过,一条协程链是由asyncio.Task牵头组成的,后续的所有成功和异常都会在这条链上传播,而取消本质上就是一种异常,所以也可以在协程链上传播。shield为了杜绝运行的可等待对象收到协程链的异常传播又能让协程链知道可等待对象的执行结果,会先让可等待对象在另外一条协程链运行,然后创建一个容器接到原来链上,并在可等待对象执行完成的时候把结果告诉容器,由容器把结果传播到原有的协程链上,对应的源码如下:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 def shield (arg ):if inner.done():return innerdef _inner_done_callback (inner ):if outer.cancelled():if not inner.cancelled():return if inner.cancelled():else :if exc is not None :else :def _outer_done_callback (outer ):if not inner.done():return outer

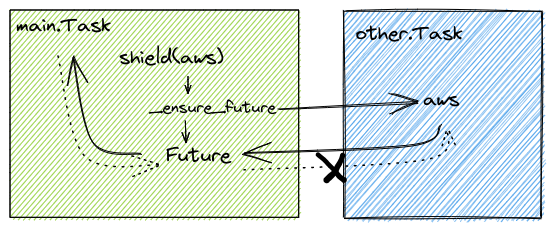

通过源码可以发现shield被调用的时候(假设驱动调用shield的Task名为main.Task),会先通过_ensure_future辅助函数创建一个Task(other.Task)在后台异步运行可等待对象,驱动可等待对象的运行,由于是新的Task驱动着可等待对象的执行,所以main.Task的任何状态不会传播到当前的可等待对象。Future容器,并在other.Task和Future容器挂上完成的回调使他们在完成的时候都能通知到对方,最后返回Future容器给main.Task,使main.Task能够间接的知道可等待对象的运行结果,如下图:

不过Future容器完成的回调只是把托管可等待对象的other.Task回调给移除了,导致main.Task的状态不会同步到other.Task中(图中Future通知可等待对象aws的通道是不通的),进而不会影响到托管的可等待对象。other.Task完成的回调会把任何状态同步到Future中,进而影响到main.Task。

3.超时–asyncio.wait_for asyncio.wait_for可以托管可等待对象,直到可等待对象完成,不过可等待对象在设定的时间内还没执行完成时会被直接取消执行并抛出asyncio.TimeoutError异常。asyncio.shield和asyncio.sleep,它一样会为可等待对象创建一个Future容器,并在容器上挂了一个超时的回调和可等待对象执行结束的回调,接着就等待容器执行结束。asyncio.wait_for之前,先了解他用到的两个辅助函数_cancel_and_wait和_release_waiter,他们的源码如下:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 def _release_waiter (waiter, *args ):if not waiter.done():None )async def _cancel_and_wait (fut, loop ):try :await waiterfinally :

可以看出源码比较简单,他们的作用都是为了确保可等待对象能完全执行结束才返回,其中_release_waiter是确保可等待对象一定被设置为执行结束,而_cancel_and_wait是为了确保能等到可等待对象被取消且完整结束时才返回。

可等待对象的cancel方法可以认为是异步的,调用后需要等事件循环再次调用可等待对象时,可等待对象才会被取消。而_cancel_and_wait通过一个容器来规避这个问题,使取消这个操作变为同步的,这个方法在某些开发场景经常被使用,如果不是私有API就更好了。

接下来就可以通过wait_for的源码了解他的执行逻辑了,源码如下:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 async def wait_for (fut, timeout ):if timeout is None :return await futif timeout <= 0 :if fut.done():return fut.result()await _cancel_and_wait(fut, loop=loop)try :return fut.result()except exceptions.CancelledError as exc:raise exceptions.TimeoutError() from exctry :try :await waiterexcept exceptions.CancelledError:if fut.done():return fut.result()else :await _cancel_and_wait(fut, loop=loop)raise if fut.done():return fut.result()else :await _cancel_and_wait(fut, loop=loop)try :return fut.result()except exceptions.CancelledError as exc:raise exceptions.TimeoutError() from excfinally :

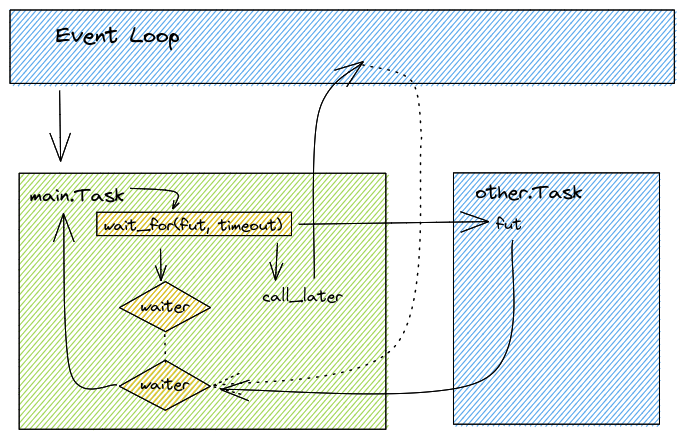

wait_for的源码为了兼容各种情况,代码复杂度比较高,同时超时参数小于等于0跟大于0的逻辑是一样的,分开写只是为了避免在小于等于0时创建了一些额外的对象,在精简了一些asyncio.Task传播异常给waiter的逻辑后,wait_for的执行逻辑如下图:

fut为可等待对象,timeout为超时时间

可以看到wait_for的主要逻辑是先创建一个名为waiter的容器,接着通过loop.call_later指定在多少时间后释放容器,然后再通过ensure_future使另一个asyncio.Task来托管可等待对象,并安排执行完毕的时候释放容器,再等待waiter容器的执行直到被释放。当容器被释放的时候再判断可等待对象是否执行完毕,如果执行完毕了就直接返回,否则抛出超时异常。

4.简单的等待–wait asyncio.wait用于等待一批可等待对象,当有一个可等待对象执行完成或者出现异常的时候才会返回数据(具体还是要看return_when指定的条件,默认为所有等待对象结束或取消时才返回),需要注意的是wait虽然支持timeout参数,但是在超时的试试不会取消可等待对象,也不会抛出超时的异常,只会把完成的可等待对象放在完成的集合,把未完成的可等待对象放在未完成的集合并返回,如下代码:

1 2 3 4 5 6 7 8 9 10 11 12 import asyncioasync def main ():return await asyncio.wait(1 ))},0.5 if __name__ == "__main__" :

这段代码可以正常的运作,不会抛出超时错,不过还要注意的是在后续版本中asyncio.wait只支持Task对象,如果想要传入的是coro和Future对象,则需要开发者自己手动转换。wait的逻辑与wait_for类似,源码如下:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 async def _wait (fs, timeout, return_when, loop ):assert fs, 'Set of Futures is empty.' None if timeout is not None :len (fs)def _on_completion (f ):nonlocal counter1 if (counter <= 0 or or and not f.cancelled() and f.exception() is not None )if timeout_handle is not None :if not waiter.done():None )for f in fs:try :await waiterfinally :if timeout_handle is not None :for f in fs:set (), set ()for f in fs:if f.done():else :return done, pending

可以看到wait_for的复杂度没有wait高,而且可以看到asyncio.wait是等waiter这个容器执行完并移除可等待对象上面的_on_completion回调后才把可等待对象按照是否完成区分到done和pending两个集合,这样的准确度比在_on_completion高一些,但是如果开发者在处理集合时触发一些异步操作也可能导致pending集合中的部分可等待对象变为完成的,如下代码:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 import asyncioasync def main ():for _ in range (10 )]await asyncio.wait(f_list, timeout=1 )len (done), len (pending))for i in pending if i.done()])1 ].set_result(True )for i in pending if i.done()])if __name__ == "__main__" :

通过输出可以发现,在asyncio.wait执行完毕后,pending中的完成的元素只有0个,而在后续强制为其中的一个Future设置数据后,pending中完成的元素有1个了。

5.迭代可等待对象的完成–asyncio.as_completed asyncio.wait的机制是只要被触发就会返回,其他尚未完成的可等待对象需要开发者自己在处理,而asyncio.as_completed可以确保每个可等待对象完成返回数据或者超时时抛出异常,使用方法如下:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 import asyncioasync def sub (i ):await asyncio.sleep(i)return iasync def main ():for f in asyncio.as_completed([sub(i) for i in range (5 )], timeout=3 ):await f)if __name__ == "__main__" :

该程序并发执行5个协程,其中执行最久的时间是5秒,而as_completed设置的超时为3秒。通过输出可以发现,每当一个可等待对象执行结束时就会把数据抛出来,当超时则会抛出超时错误。为了能达每有一个可等待对象就返回一次数据的效果,as_completed通过一个队列来维护数据的返回,它的源码如下:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 def as_completed (fs, *, timeout=None ):from .queues import Queue for f in set (fs)}None def _on_timeout ():for f in todo:None ) def _on_completion (f ):if not todo:return if not todo and timeout_handle is not None :async def _wait_for_one ():await done.get()if f is None :raise exceptions.TimeoutErrorreturn f.result()for f in todo:if todo and timeout is not None :for _ in range (len (todo)):yield _wait_for_one()

通过源码可以发现可等待对象就像生产者一样,执行结束的时候就会把结果投递给队列,同时as_completed会迭代跟可等待对象的数量一样的_wait_for_one协程函数,供开发者消费数据。不过需要注意的是as_completed在超时的时候,并不会取消尚未完成的可等待对象,他们会变为不可控的状态,在某些时候会造成内存溢出,如下示例代码:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 import asyncioimport randomasync def sub ():if random.choice([0 , 1 ]) == 0 :None )return await fasync def main ():try :for f in asyncio.as_completed([sub() for i in range (5 )], timeout=1 ):await f)except asyncio.TimeoutError:pass 0 for i in asyncio.all_tasks():if i._coro.__name__ == sub.__name__:1 "runing task by name sub:" , cnt)if __name__ == "__main__" :

通过结果(由于采用随机,结果可能不一样)可以发现,sub成功执行完成的数量有3个(输出None),而在as_completed触发超时后仍有两个sub在执行中,这时的两个sub成为无人管理的可等待对象,除非开发者通过asyncio.all_tasks去找到他并清理掉,否则这几个可等待对象会一直伴随着程序运行,这很容易造成内存溢出。